中国初创公司 DeepSeek 近日公开推出了一系列大型语言模型(LLM),号称性能可与 OpenAI 的 o1 模型抗衡。成立仅两年的 DeepSeek 由创业者梁文锋创办,其背后有量化对冲基金「高飞资本」的资金支持。DeepSeek 模型以 MIT 许可的形式免费开放下载,宣称在推理、数学等方面达到与主流美系大模型相当的水平。本文将从模型亮点、推理表现、使用方法等角度,一探这款免费对标 o1 的 AI 新星。

1. 为何 DeepSeek R1 值得关注?

DeepSeek 在 2024 年底正式发布了 V3 大模型,而最新的 R1 则是在 V3 基础上聚焦「链式思考(chain-of-thought, CoT)」推理能力的一次深度微调。与许多西方闭源模型不同,R1 不仅将训练权重开源,而且采用宽松的 MIT 协议,方便开发者在商用场景中使用。

- 训练与成本:DeepSeek 表示,其最大规模的 R1 模型拥有 6710 亿参数(其中 370 亿参数在推理时被激活),训练耗时约 278.8 万 GPU 小时,使用 2048 张英伟达 H800 GPU,总成本约 558 万美元,相比美系厂商动辄数亿美元的投资显得“相当节省”。

- 开源共享:R1 模型及其蒸馏版本(参数规模从 1.5B 到 70B 不等)均已上传至 Hugging Face。得益于 MIT 许可证,开发者可任意在项目中集成、二次开发。

2. 真实测试:DeepSeek R1 能否与 o1 抗衡?

我们对 R1 及其蒸馏版本进行了多种实测,包括最常见的「LLM 容易翻车」问题——数数、简单数学运算、推理规划、空间关系等,力图探究 DeepSeek 在实际使用场景中的表现。

(1)简单字符统计

- “strawberry” 的 R 数量:主力 R1 大模型能够正确回答「3 个 R」,与 OpenAI o1 一样并未像许多 LLM 那样犯“两位数”错误。

- 小规模蒸馏版本(1.5B、7B、8B)不太稳定,部分测试会答成两三个版本不一,但 14B 及以上规模的表现更接近 671B 大模型。

(2)基础数学运算

- 问题示例:2485 × 8919, 23929 ÷ 5783, 解方程 X * 3 / 67 = 27

- R1 大模型能快速给出 2485 × 8919 = 22163715,并正确求出 X = 603;但在除法时,仅给出了小数点后三位,没有像有些模型那样四舍五入到小数点后四位。

- 小规模蒸馏模型对大整数和小数推断差异较大,8B、7B 及 1.5B 经常答非所问;14B 以上相对准确度提升。

(3)推理与空间关系

- 狼、羊、白菜过河:R1 大模型一次性就给出“船有三个隔间”的最佳解,8B~14B 版本常常忽略该点或陷入绕圈思考;1.5B 模型甚至在输出“思考链”时卡住“死循环”。

- 圆圈站位:Alan, Bob, Colin, Dave, Emily 五人依次相邻,问谁在 Alan 右边?部分蒸馏模型会翻车。R1 大模型多数情况下能回答“Bob”,但重复提问时偶有失误。

(4)政治敏感议题

- 跟很多中国公司大模型类似,R1 明显做了审查,对 政治敏感话题直接拒绝或引导至其他话题。蒸馏版的 14B、8B、7B 也同样如此——无一例外均显示“无法回答”或“对不起,我不能回答这个话题”,这与已有的 QQwen、Ernie 等国产模型现状相似。

3. 链式思考:推理更强,速度却更慢

R1 最大特色在于「chain-of-thought」。模型会先生成内部思维过程,然后再输出最终答案,减少“幻觉”与逻辑错误。

- 推理时长变长:因在生成答案前需产生大量「思考」tokens,整体响应速度显著慢于同规模的普通 LLM。如果是 8B、14B 级别蒸馏版,部分场景耗时依然可忍受;但 32B 或以上规模的模型若在本地推理,速度会明显下滑。

- 硬件要求更高:更多 tokens 意味着更多内存带宽占用。对 GPU 环境要求高,若想用 32B 以上模型最好配备 24GB 或更大显存,还要尝试 4-bit 量化,否则无法容纳。

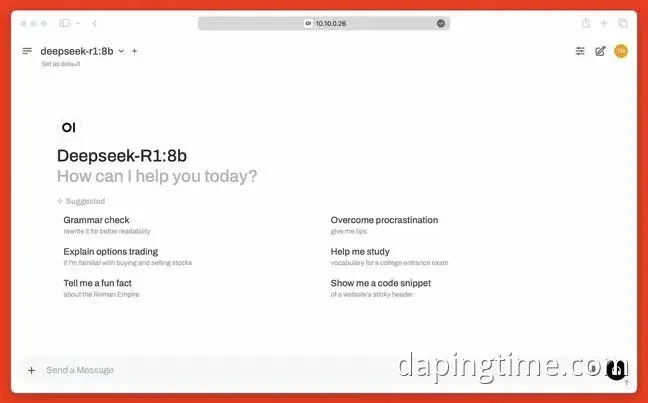

4. 如何在本地使用 DeepSeek R1?

如果你想亲自体验 DeepSeek R1,却没有堆叠数十张 H100 的条件,可借助 Ollama 或者 Open WebUI。它们提供了易于安装、运行的环境,适合在家用 PC 或服务器上试玩 R1 蒸馏模型。

- 准备工作GPU 要有至少 8GB 显存(跑 8B、7B、1.5B 量化版),如要尝试 32B 或 70B 必须 24GB 显存以上;安装 Docker(在容器里更便捷地运行 Open WebUI),并确保命令行环境可用。

- 安装 OllamamacOS/Windows 可从 ollama.com 直接下载安装包;Linux 环境输入 curl -fsSL https://ollama.com/install.sh | sh 一键安装,然后测试 ollama version。

- 下载并运行模型例: ollama pull deepseek-r1:8b 获取 8B 量化版模型;之后 ollama run deepseek-r1:8b 即可在命令行中向模型提问。

- 部署 Open WebUI先确保 Docker 已安装,再执行:perl复制编辑docker run -d --network=host -v open-webui:/app/backend/data \ -e OLLAMA_BASE_URL=http://127.0.0.1:11434 --name open-webui \ --restart always ghcr.io/open-webui/open-webui:main 打开 http://localhost:8080 查看前端界面。在模型下拉菜单里选择「deepseek-r1:8b」(或任意下载好的尺寸),即可在浏览器里与 R1 互动。

5. DeepSeek R1的未来与挑战

在中国 AI 圈,DeepSeek 用“中等投入+高效算力+MIT 协议开源”的组合拳,闯出名声。R1 在文字理解、推理方面的确有可圈可点之处,尤其在推理能力与开源度上,让开发者眼前一亮。不过,实际测试也显示,R1 并不具备完美答案——数理计算依然有失败案例,政治话题有敏感审核,CoT 虽提升逻辑但牺牲了速度。

短期来看,DeepSeek R1 不会取代 GPT-4o 或 Claude 等顶级闭源大模型在高端商用领域的地位。但对于想要更自由商用、更透明可定制的团队和个人来说,R1 的到来无疑提供了新的选择。从长远看,R1 也象征了“中国AI团队”在开源大模型上的再一次尝试——能否打破美系大厂的技术垄断,还有待观察,但至少值得大家亲自体验一番。

相关文章

DeepSeek-R1 本地部署全攻略:使用 Ollama 轻松搭建 AI 环境

清华团队突破大模型算力瓶颈,单卡RTX 4090运行满血版DeepSeek引领AI创新

微软为 Copilot+ PC 引入 DeepSeek 7B 与 14B 模型 助力本地 AI 应用革新

DeepSeek发布突破性推理模型K1.5:开源与性能革命,AI领域迎来新纪元

DeepSeek挑战OpenAI?美国拟升级AI禁令,全球AI竞争进入“新冷战”

DeepSeek引爆AI“下半场”?十条判断带你看穿未来

版权声明:除非特别标注,否则均为本站原创文章,转载时请以链接形式注明文章出处。

相关标签:

R1

模型

DeepSeek

推理

蒸馏

8B

15B

开源

LLM

o1